- Apple kondigde onlangs aan met software op de iPhone actief te gaan speuren naar afbeeldingen met daarop kindermisbruik.

- Veel critici zien de stap van Apple als een inbreuk op de privacy en waarschuwen dat dit de deur opent naar erger.

- IT-specialisten hebben uitgevonden dat de software van Apple relatief makkelijk te misleiden is.

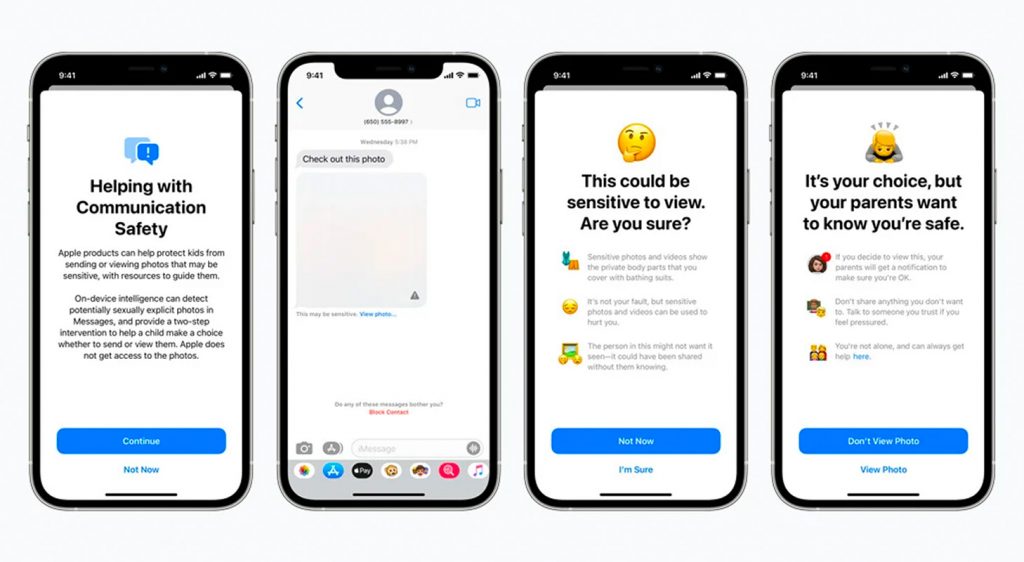

Enkele weken geleden liet Apple weten dat de Amerikaanse technologiereus met speciale software, die op iPhones geïnstalleerd staat, gaat zoeken naar afbeeldingen waar mogelijk kindermisbruik op voorkomt. Het idee hierachter is dat het bedrijf kindermisbruik in een vroeg stadium kan ontdekken en met die bevinding naar de politie kan stappen.

Critici keken verder dan de goedbedoelde aankondiging van de techgigant. Zij beweerden al snel dat het een stap te ver is om op een privételefoon van mensen te gaan rondneuzen. Het zou de deur openzetten voor vergelijkbare acties, maar met minder goedbedoelde intenties.

Er zou bijvoorbeeld druk van overheden op Apple uitgeoefend kunnen worden om ook naar andere dingen te gaan zoeken op telefoons. Apple beweert dat het al dit soort verzoeken linea recta naar de prullenbak verwijst.

Aangepaste afbeeldingen worden niet herkend

Maar hoe goed de bedoelingen van Apple ook zijn en hoe goed het bedrijf ook rekening houdt met de privacy van de iPhonebezitter, toch lijkt de software niet waterdicht. Githubgebruiker Asuhariet Ygvar maakte de speursoftware van Apple na op basis van een versie die hij vond in iOS. Daarmee liet hij zien hoe de software omgaat met afbeeldingen en hoe deze matcht met die uit de database van bekende kindermisbruikfoto's.

Ygvar ontdekte dat de software, NeuralHash genoemd, grotere en kleinere versies van afbeeldingen herkende. Zodra diezelfde afbeeldingen gekanteld, ondersteboven of bijgeknipt waren, werden de foto's echter niet meer gemarkeerd.

Githubgebruiker Cory Cornelius kwam met meer ingrijpende ontdekking: twee afbeeldingen kunnen dezelfde hash (identificatiecode) hebben. Dit kan ervoor zorgen dat een foto zonder enig spoor van kindermisbruik toch als zodanig gemarkeerd wordt.

Apple gebruikt NeuralHash om de zogenoemde hash (een unieke identificatiecode, of digitale vingerafdruk) van een afbeelding te vergelijken met die van foto's uit de bekende database. Matcht er één, dan wordt hij gemarkeerd.

Bij 30 positief gemarkeerde foto's krijgt een medewerker van Apple een melding. Deze bekijkt de foto's en stelt definitief vast of het om kindermisbruik gaat.

Extra controle op de servers van Apple

Beide bevindingen geven inzicht in hoe het systeem misbruikt kan worden. Voor iemand met foto's met kindermisbruik is het een kwestie van de afbeelding minimaal aanpassen en Apple tast in het duister. Andersom kan het ook voorkomen dat Apple foutieve meldingen binnenkrijgt.

In theorie is het mogelijk om onschuldig ogende foto's met een bekende hash op iemands telefoon te zetten, waardoor deze naar boven komt bij Apple. Dit zou ondervangen kunnen worden door een medewerker van Apple die daadwerkelijk de foto's bekijkt.

Apple liet tegenover The Verge weten dat het dergelijke bevindingen al verwachtte. Ook heeft het bedrijf al een oplossing voor het probleem met de dubbele hashes. Als de dubbel gemarkeerde foto's van een iPhone op de servers van Apple terechtkomen, dan wordt er een extra controle gedaan door een ander algoritme. Dit zou de foutief gemarkeerde foto's eruit moeten halen en daarmee de markering ongedaan maken.

Of Apple de software aanpast om ook de aangepaste afbeeldingen te leren herkennen, is niet duidelijk. Deze technologie bestaat al sinds 2009, maar is van Microsoft. Voor nu helpen deze bevindingen Apple in ieder geval niet in de strijd om de critici te overtuigen van hun zaak.