- Een Chinees AI-systeem om emoties te herkennen kan gezichtsuitdrukkingen monitoren en analyseren hoe mensen zich voelen.

- Een glimlach faken haalt weinig uit: het systeem kan naar verluidt zien of de getoonde emotie echt is of niet.

- Het bedrijf achter het AI-systeem rekent Huawei, China Mobile en PetroChina tot zijn klanten, maar het is niet duidelijk of deze kunstmatige intelligentie daadwerkelijk wordt ingezet in hun kantoren.

Je hebt twaalf uur gewerkt en je voelt je moe en gefrustreerd, maar toch dwing je jezelf om een neutrale uitdrukking op je gezicht te houden. Je bent te uitgeput om te blijven typen, maar je kan niet gapen, grijnzen of fronsen want een alziend oog houdt je in de gaten. Het oog brengt je emoties in kaart en – vergis je niet – zal vertellen wanneer je een beetje te boos kijkt.

Nee, dit is niet het plot van een sciencefictionfilm of een nieuwe Black Mirror-aflevering. Misschien is het al realiteit voor sommige Chinese werknemers die voor grote technologiebedrijven werken.

Een AI-systeem voor emotieherkenning ontwikkeld door het Chinese bedrijf Taigusys kan de gezichtsuitdrukkingen van mensen volgen en gedetailleerde rapporten maken over hoe iemand zich precies voelt. Onderzoekers zeggen echter dat zulke systemen niet alleen vaak onnauwkeurig zijn, maar ook zeer onethisch.

In een onderzoeksverhaal van The Guardian dat in mei is gepubliceerd is het AI-systeem voor het eerst genoemd. Taigusys schaart multinationals als Huawei, China Mobile, China Unicom en PetroChina onder haar belangrijkste klanten, hoewel het onduidelijk is of deze bedrijven deze kunstmatige intelligentie ook daadwerkelijk gebruiken.

Insider nam contact op met Taigusys en de 36 bedrijven op de klantenlijst en geen van alleen wilden hierop reageren

Hoe werkt het?

Taigusys beweert op zijn website dat het systeem helpt om "nieuwe uitdagingen aan te gaan" en dat het "conflicten kan minimaliseren" die worden veroorzaakt door emotioneel en confronterend gedrag.

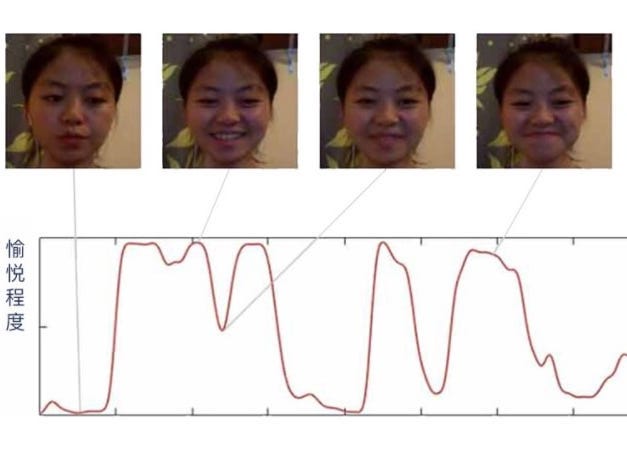

Dit gebeurt door een AI-systeem dat de gezichtsuitdrukkingen van meerdere personen tegelijk kan beoordelen. Een algoritme beoordeelt vervolgens alle gezichtsuitdrukkingen en biometrische signalen en evalueert ze op verschillende schalen die door Taigusys zijn opgesteld.

Het programma zoekt naar "goede emoties" zoals geluk, verrassing en worden geroerd door iets positiefs. De kunstmatige intelligentie controleert ook iemands gezicht op negatieve emoties zoals walging, verdriet, verwarring, minachting en woede. Neutrale emoties, zoals hoe "gefocust" men is op een taak, worden ook meegenomen.

Taigusys beweert dat de software zo geavanceerd is dat het kan detecteren wanneer iemand een glimlach faket.

De emotieherkenningssoftware zou ook rapporten kunnen maken over mensen waarin ze aanbevelingen krijgen voor "emotionele ondersteuning' als ze de "aanbevolen grenzen voor negatieve emoties" overschrijden.

"Door de analyse van iemands gelaatstrekken kan het systeem berekenen hoe confronterend, gestrest of nerveus iemand is, naast andere statistieken. We kunnen ook iemands emotionele reactie analyseren en uitzoeken of ze iets verdachts van plan zijn", zegt het bedrijf in een productomschrijving van het systeem.

Activisten dringen aan op voorzichtigheid bij het gebruik van zulke programma's

Mensenrechtenactivisten en techexperts die Insider sprak, slaan alarm over het inzetten van zulke programma's. Ze merken op dat emotieherkenningssystemen fundamenteel geworteld zijn in onethische en onwetenschappelijke ideeën.

Vidushi Marda, programmamedewerker bij de Britse mensenrechtenorganisatie Article 19, en Shazeda Ahmed, PhD-kandidaat aan de UC Berkeley School of Information, doen gezamenlijk onderzoek naar de Chinese markt voor gezichtsherkenning.

Uit hun studie die in januari werd gepubliceerd blijkt dat maar liefst 27 bedrijven in China werken aan kunstmatige intelligentie die emoties kan herkennen. Een van die bedrijven is Taigusys.

"Als zulke technologie wordt uitgerold schendt het de ethische en wettelijke rechten van werknemers op de werkplek. Ook op een privéwerkplek zijn er nog steeds verwachtingen van privacy en waardigheid en hebben werknemers het recht om vrij te handelen en te denken", aldus Marda.

Ze merkt op dat emotieherkenningssystemen zijn gebaseerd op pseudowetenschap en uitgaan van zwakke en wetenschappelijk niet onderbouwde veronderstellingen dat iemands gezichtsuitdrukkingen verband houden met iemands innerlijke emotionele toestand.

"Er is geen manier om deze technologieën te 'optimaliseren' zodat ze ethisch verantwoord ingezet kunnen worden, omdat de aannames waarop ze ze zijn gebouwd zelf onethisch zijn", zegt Marda.

Bovendien, stelt Ahmed, zou intensief alziend toezicht die zulke technologie oplegt, kunnen leiden tot zelfcensuur en het sturen van gedrag om zo het systeem te bespelen.

Daniel Leufer, beleidsanalist Europa bij de non-profitorganisatie voor digitale burgerrechten Access Now, vertelt aan Insider dat zelfs als het werkt programma's voor het herkennen van emoties diverse mensenrechten "grof schenden", waaronder iemands recht op privacy, vrije meningsuiting en vrijheid van denken.

"Het ergste van alles is dat al deze overtredingen mogelijk plaatsvinden, zelfs als emotieherkenning wetenschappelijk niet mogelijk is. Alleen al het feit dat mensen geloven dat het zo is en systemen creëren en implementeren die beweren het te doen, heeft reële gevolgen voor mensen", zegt Leufer.

"Een samenleving die onze emoties in de gaten houdt, is een samenleving die sommigen zal belonen en anderen zal straffen. Zijn bepaalde emoties voorspellend voor misdaad of lage productiviteit?", merkt hoogleraar politieke wetenschappen aan Stanford Rob Reich op. Hij is ook co-auteur van een onlangs verschenen boek over ethiek en technologie getiteld: 'System Error: Where Big Tech Went Wrong and How We Can Reboot'.

"Big Brother zal toekijken en toegerust zijn om een emotioneel regime af te dwingen. Het resultaat is een systematische schending van privacy en degradatie van de mensheid", aldus Reich.

"Het is nooit ethisch om kunstmatige intelligentie te gebruiken om de emoties van mensen in de gaten te houden, vooral niet als degenen die de surveillance uitvoeren een machtspositie hebben ten opzichte van degenen die worden gecontroleerd zoals werkgevers, de politie en de overheid", voegt Leufer toe.

Dit is misschien de reden waarom gevangenissen behoren tot de weinige werkplekken die openlijk hebben toegegeven het programma te gebruiken.

The Guardian sprak met Chen Wei, algemeen directeur bij Taigusys, die vertelde dat de systemen van het bedrijf zijn geïnstalleerd in 300 gevangenissen en detentiecentra in China. "Het systeem is verbonden met ongeveer 60.000 camera's in vergelijkbare faciliteiten en heeft eraan bijgedragen dat gevangenen 'volgzamer' werden", zegt Chen.

Met het systeem kunnen de autoriteiten mensen 24 uur per dag volgen.

"Geweld en zelfmoord komen veel voor in detentiecentra. Ook al slaat de politie tegenwoordig geen gevangenen, ze proberen ze vaak emotioneel te breken door ze niet te laten slapen. Als gevolg hiervan zullen sommige gevangen een zenuwinzinking krijgen en proberen zelfmoord te plegen. En ons systeem zal helpen voorkomen dat dit gebeurt", vertelt Chen aan The Guardian.

Naast de ethische implicaties betwijfelen velen of de technologie verfijnd genoeg is om een nauwkeurig genoeg beeld te schetsen

Desmond Ong, hoogleraar informatiesystemen en analyse van de nationale universiteit van Singapore, denkt dat de software mogelijk kan helpen bij het "identificeren van gevaarlijke situaties zoals vermoeide, dronken of geestelijk onwel geworden piloten en machinisten."

Maar, voegde hij eraan toe, "het kan ook gebruikt worden om werknemers onterecht te straffen of hun prestaties op onmenselijke wijze te optimaliseren, zoals 'empathie' benoemen als belangrijke prestatie-indicator voor callcentermedewerkers."

Ong merkt op dat kunstmatige intelligentie zoals die ontwikkeld wordt door Taigusys ook de complexiteit van menselijke emotionele expressie ondermijnt door mensen te reduceren tot basisemoties.

"Gebruik het gewoon niet, ontwikkel het niet en financier het niet. Het is wetenschappelijk wankel, het schendt een reeks aan fundamentele rechten en het is ook gewoon griezelig", zegt hij.

Bovendien is het onduidelijk hoe goed kunstmatige intelligentie de complexiteit van emoties kan interpreteren.

Sandra Wachter, universiteit hoofddocent en onderzoeker aan het Oxford Internet Institute aan de universiteit van Oxford, zegt dat het onwaarschijnlijk is dat een algoritme de zeer complexe toestand van mensen via alleen gezichtsuitdrukkingen nauwkeurig kan begrijpen.

Ze merkt bijvoorbeeld op dat vrouwen vaak aanleren om beleefd te glimlachen, omdat het een sociale norm is. Maar dat is misschien geen teken van geluk of instemming is.

"Het toepassen van emotieherkenningssoftware op werknemers vormt ook een bedreiging voor de diversiteit, omdat het mensen dwingt te handelen op een manier die voldoet aan een algoritmische en kunstmatige 'mainstream'-standaard. Dat is een inbreuk op de autonomie van mensen om zich vrij uit te drukken", aldus Wachter.

"We zien een botsing met fundamentele mensenrechten zoals vrije meningsuiting en het recht op privacy", voegt ze eraan toe.

Lees meer over China:

- 22 angstaanjagende foto’s van hoe China gezichtsherkenning gebruikt om burgers in de gaten te houden

- De val van Jack Ma toont het ongemak van China met onafhankelijke ondernemers

- Zo rolt China zijn digitale munt uit – met de e-yuan kan de Chinese overheid alle geldtransacties volgen

- 12 foto’s van gloednieuwe Chinese spooksteden die wachten op bewoners